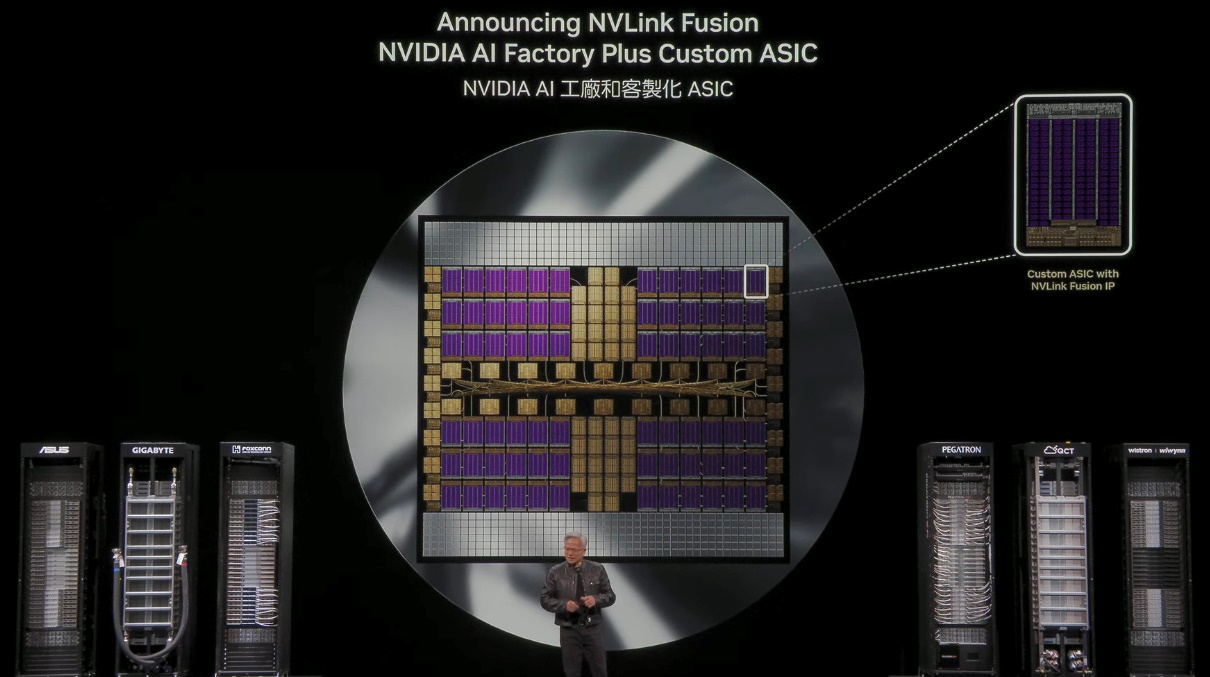

Jakarta, Komite.id – Dalam pidato utamanya, Jensen Huang meluncurkan produk Super Switch dengan Bandwidth super tinggi untuk komunikasi GPU ke GPU dan Memori, yang disebut NVIDIA NV Link Fusion.

Nvidia NV Link Fusion membantu mitranya meningkatkan skala sistem mereka, apa pun sistem yang mereka pilih, Huang mengumumkan NVLink Fusion, arsitektur baru yang memungkinkan hyperscaler untuk membuat solusi komputasi semi-kustom dengan interkoneksi NVLink NVIDIA.

Teknologi ini bertujuan untuk memecah kemacetan lalu lintas timur-barat tradisional di pusat data, memungkinkan skala AI tingkat baru dan desain sistem yang lebih fleksibel dan dioptimalkan yang disesuaikan dengan beban kerja AI tertentu menuju Pusat Data AI atau pabrik AI. “Badan kerja yang luar biasa ini sekarang menjadi fleksibel dan terbuka bagi siapa saja untuk diintegrasikan,” kata Huang.

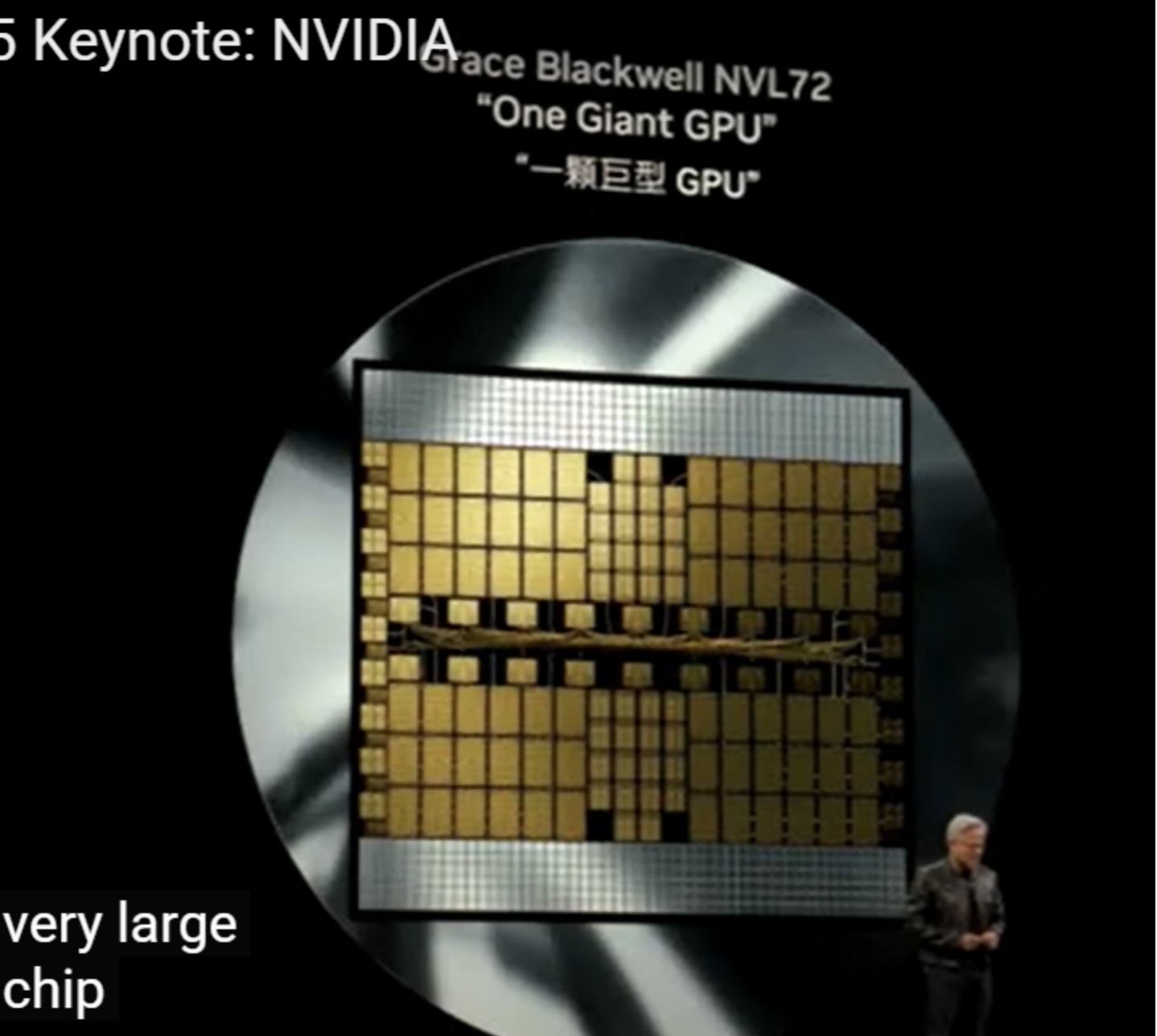

Dalam kasus Blackwell, NVIDIA bahkan menghubungkan dua chip superkomputer menjadi satu untuk memungkinkan dan mencapai skala yang lebih besar. TSMC bekerja sama dengan NVIDIA untuk menciptakan chip raksasa ini atau apa yang disebut sebagai scale-up.

Namun, Jensen masih memimpikan chip yang jauh lebih besar dari itu. Karena itulah NVIDIA menciptakan NVLink Switch, saklar tercepat di dunia dengan kecepatan 7,2 terabyte per detik. Sembilan saklar ini dimasukkan ke dalam Blackwell Rack.

NVLink Spine atau Tulang Punggung Sistem

Kesembilan saklar tersebut dihubungkan oleh sebuah keajaiban seberat 70 pon: NVLink Spine, yang terdiri dari kabel sepanjang 2 mil. Sebanyak 5.000 kabel koaksial yang disesuaikan impedansinya menghubungkan seluruh 72 GPUmelalui NVLink Switch dengan bandwidth sebesar 130 terabyte per detik melintasi spine ini.

Sebagai perbandingan, lalu lintas puncak seluruh internet dunia adalah 900 terabyte per detik. Jika dibagi 8, maka NVLink Spine ini memindahkan data lebih banyak daripada seluruh internet. Satu NVLink Spine melintasi 9 NVLink Switch, sehingga setiap GPU dapat berkomunikasi dengan semua GPU lainnya secara bersamaan.

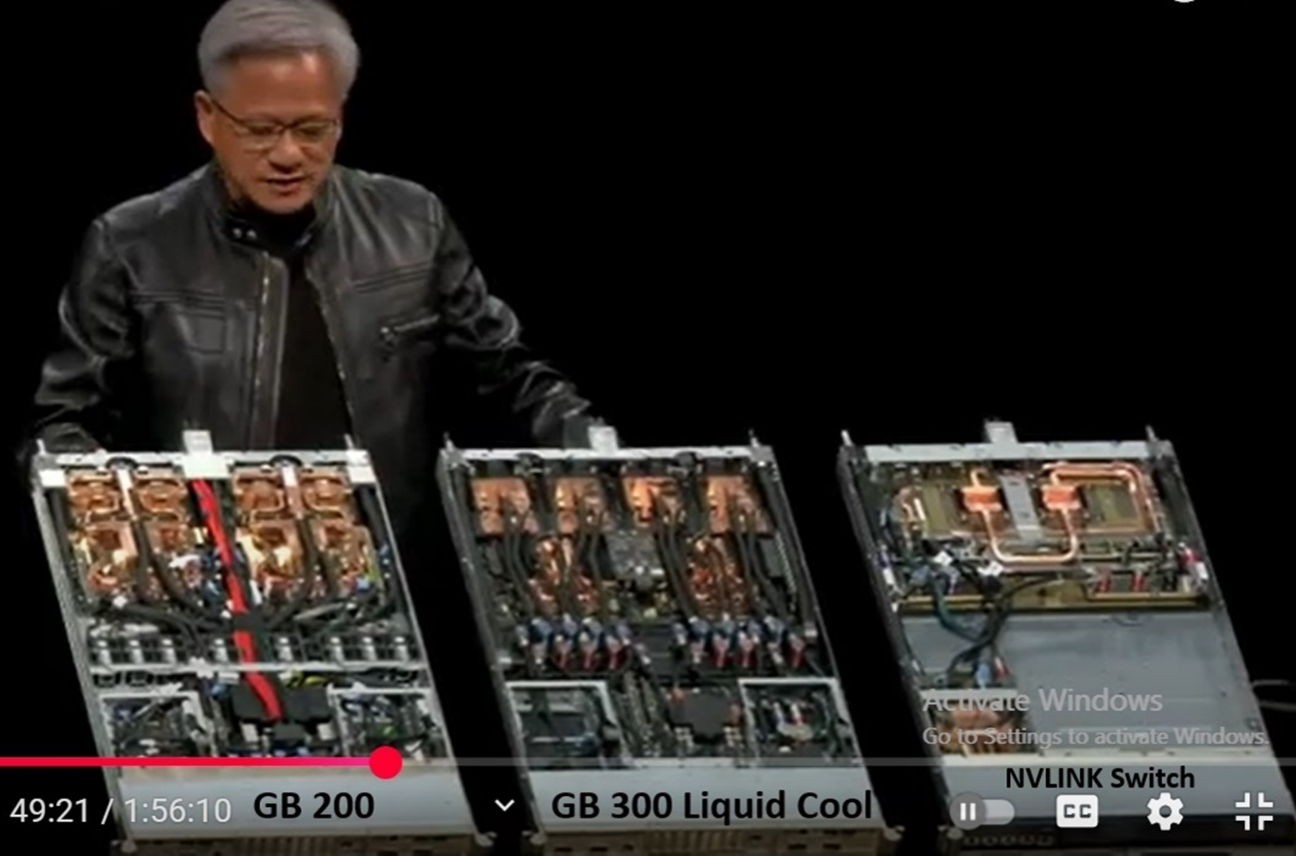

Inilah keajaiban dari GB200. Karena ada batas seberapa jauh sebuah sirkuit bisa mengirimkan data, maka desain ini merupakan pencapaian tertinggi dalam menghubungkan chip ke saklar, lalu ke spine, dan ke chip lainnya. Batas teknis inilah yang menyebabkan semua komponen harus berada dalam satu rak. Dan satu rak ini mengonsumsi daya 120 kilowatt, itulah mengapa semuanya harus menggunakan sistem pendingin cair.

Kini kita memiliki kemampuan untuk memisahkan GPU dari satu motherboard dan menyebarkannya ke seluruh rak—berkat NVSwitch. Jadi, satu rak ini pada dasarnya adalah satu motherboard raksasa. Inilah keajaiban sejatinya.

Dengan itu, kita bisa benar-benar melakukan skala horizontal (scale-out). Setelah kita bisa melakukan scale-up, kini kita bisa meluaskannya menjadi sistem besar-besaran.

Perhatikan bahwa hampir semua yang dibangun NVIDIA berukuran sangat besar, karena NVIDIA bukan hanya membangun pusat data dan server, tetapi membangun pabrik AI.

Foto yang ditampilkan adalah pusat data superkomputer tercepat NVIDIA senilai $1,6 miliar, milik CoreWeave.

220 MW di Plano.

Dan ini adalah gambar Oracle Cloud Supercluster dengan daya 260 MW untuk Indonesia. Densitas daya tiap rak begitu tinggi, sehingga mereka harus menempatkan rak-rak tersebut berjauhan agar distribusi daya bisa merata dengan bantuan pendingin cair (liquid cooling).

Gambar berikutnya menunjukkan pabrik XAI Colossus dengan kapasitas 150 MW milik X (Twitter), yang digunakan untuk menjalankan Grok oleh Elon Musk, berlokasi di Memphis, Tennessee. Gambar ini menunjukkan Stargate AI Data Center yang kontroversial, dengan kapasitas 200 MW dan akan ditingkatkan hingga menjadi pabrik AI 1,2 GW di Abilene, Texas—sebuah proyek senilai US$ 500 miliar yang digagas oleh OpenAI, Oracle, dan SoftBank.

Gambar ini menunjukkan Stargate AI Data Center yang kontroversial, dengan kapasitas 200 MW dan akan ditingkatkan hingga menjadi pabrik AI 1,2 GW di Abilene, Texas—sebuah proyek senilai US$ 500 miliar yang digagas oleh OpenAI, Oracle, dan SoftBank.

Stargate ini akan menjadi pabrik AI bertenaga 1 Gigawatt, dengan nilai investasi sebesar US$ 60–80 miliar, serta tambahan US$ 40–50 miliar untuk bagian elektronik dan komputasi.

Bayangkan betapa raksasanya investasi pabrik ini di Amerika Serikat seiring memasuki era AI?

Mengapa orang membangun pabrik? Karena semakin besar investasi, semakin besar pula hasil yang bisa diperoleh—meskipun teknologinya sangat kompleks.

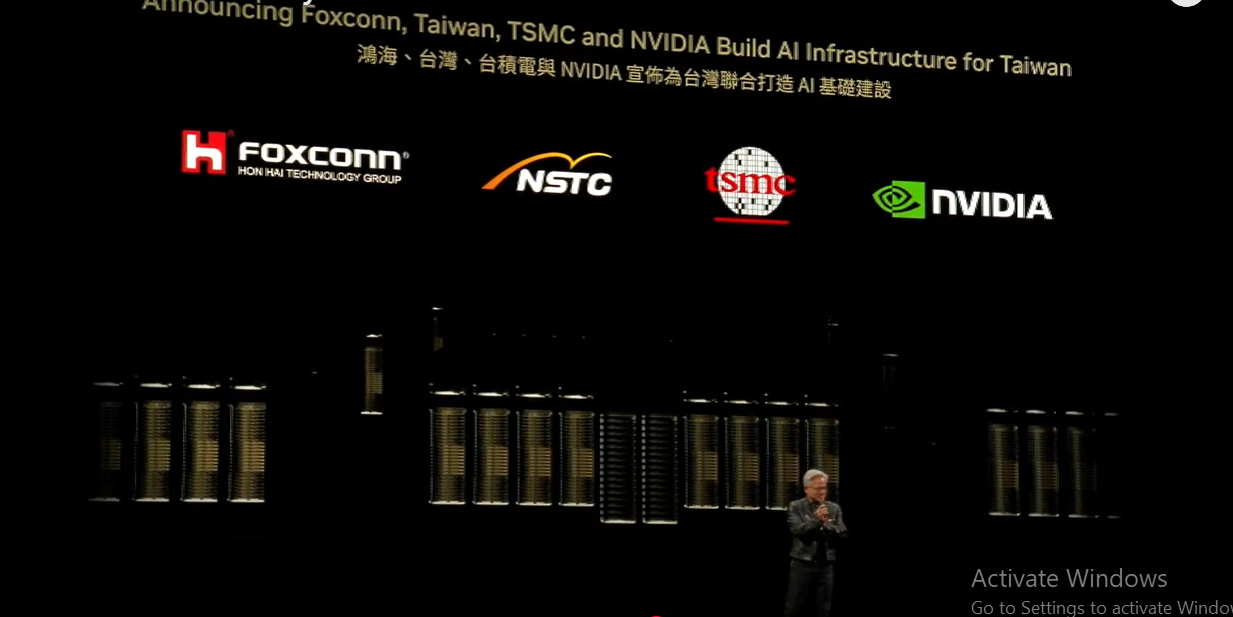

Lihat saja investasi besar-besaran di Taiwan oleh TSMC, produsen chip GPU terbesar di dunia, dan Foxconn, produsen server GPU dan pabrik AI terbesar di dunia.

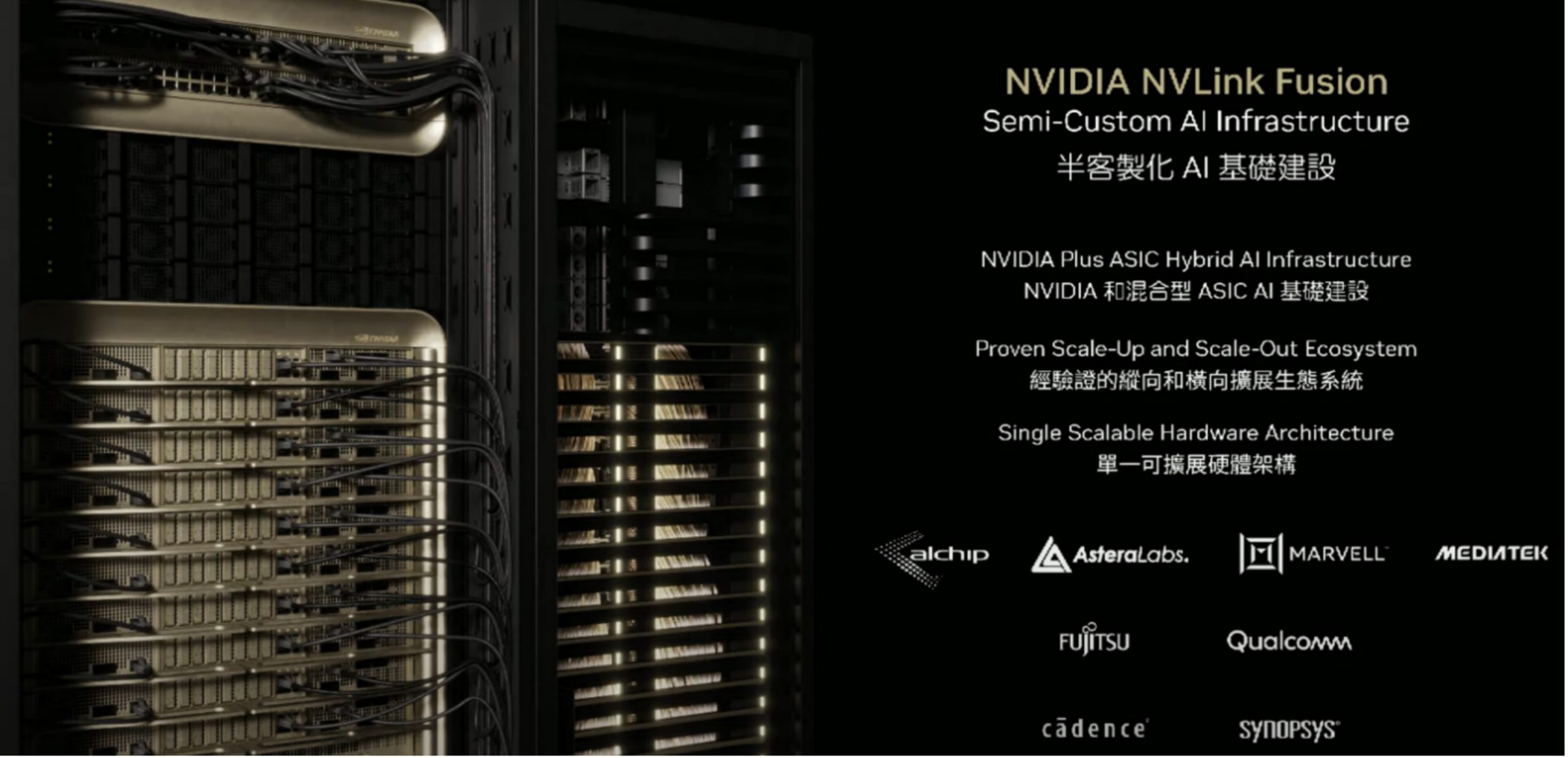

NVIDIA memiliki sejumlah mitra unggulan seperti LCHIP, Astera Labs, Marvell, dan MediaTek, serta perusahaan hyperscale. NVIDIA juga bekerja sama dengan Fujitsu dan Qualcomm, yang sedang mengembangkan CPU mereka sendiri dan menghubungkannya melalui NVLink untuk berintegrasi ke dalam ekosistem NVIDIA. Selain itu, Cadence dan Synopsys menjadi mitra NVIDIA dalam proses transfer hak kekayaan intelektual (IP) dari NVIDIA kepada mereka.

AI Fisik Industri Global & Taiwan

Jensen Huang memprediksi bahwa perusahaan-perusahaan di seluruh dunia sedang dalam proses membangun pabrik senilai total US$5 triliun.

Mengoptimalkan desain dari pabrik-pabrik ini sangat penting untuk meningkatkan produktivitas dan efisiensi mereka.

Para produsen terkemuka di Taiwan — seperti TSMC, Foxconn, Wistron, Pegatron, Delta Electronics, Quanta, GIGABYTE, dan lainnya — kini memanfaatkan NVIDIA Omniverse untuk membangun digital twin (kembaran digital).

Langkah ini mendorong gelombang baru dari AI fisik industri, khususnya dalam bidang manufaktur semikonduktor dan elektronik. Taiwan, Foxconn, TSMC, NSTC, & NVIDIA Bangun Superkomputer AI Dunia

Taiwan, Foxconn, TSMC, NSTC, & NVIDIA Bangun Superkomputer AI Dunia

Taiwan bukan hanya membangun superkomputer AI berbasis GPU untuk dunia, tetapi Jensen Huang juga mengumumkan bahwa NVIDIA berencana membangun infrastruktur AI khusus untuk Taiwan. Dalam ajang COMPUTEX 2025, diumumkan bahwa Foxconn, Pemerintah Taiwan (NSTC), NVIDIA, dan TSMC akan bekerja sama membangun superkomputer AI raksasa pertama sebagai fondasi infrastruktur AI di ekosistem AI Taiwan.

Ekosistem ini mencakup seluruh peneliti AI, ilmuwan AI, mahasiswa AI, startup AI, dan perusahaan-perusahaan besar seperti TSMC dan Foxconn yang terlibat dalam penelitian ilmiah dan pengembangan AI secara masif. Foxconn, khususnya, memiliki fokus besar dalam bidang robotika.

Memiliki infrastruktur AI kelas dunia di Taiwan sangatlah penting, karena hal ini memungkinkan NVIDIA untuk membangun chip superkomputer AI berukuran besar serta mengintegrasikan teknologi NVLink.

Saat ini, berbagai sistem GPU asal Taiwan — dari Pegatron, QCT, Foxconn, Gigabyte, hingga Asus — berfokus untuk menggabungkan chip Blackwell berukuran besar menjadi satu chip raksasa, berkat teknologi NVLink.

Kompleksitas arsitektur sistem ini, serta kekayaan ekosistem perangkat lunak yang menghubungkan 150 perusahaan di Taiwan, mencerminkan investasi industri besar-besaran dalam teknologi, software, dan manufaktur yang dibangun dalam waktu 3 tahun. Kini, siapapun dapat membangun pusat data AI (AI data center), baik menggunakan berbagai sistem GB200 atau GB300 dari NVIDIA, maupun platform komputasi akselerasi lainnya.

Dengan NVIDIA NVLink Fusion, kini Anda bisa membangun infrastruktur AI semi-kustom — beberapa dengan CPU dalam jumlah besar, yang lain dengan GPU NVIDIA atau ASIC (Application-Specific Integrated Circuit) semi-kustom.

Setiap orang kini dapat menggunakan teknologi luar biasa bernama NVLink, yang memungkinkan sistem semi-kustom tersebut dapat diskalakan dan menjadi komputer superkuat.

Beginilah cara kerja NVLink Fusion: seluruh platform superkomputer AI dari NVIDIA — termasuk GPU, CPU, chiplet NVLink Switch, TPU, dan kartu jaringan NVIDIA seperti Spectrum X atau Infiniband NIC — dibangun secara end-to-end.

Anda juga bisa menggunakan CPU lain, dan NVIDIA akan menyediakan antarmuka NVLink chip-to-chip yang menghubungkan CPU atau ASIC Anda langsung ke chip Blackwell atau chip generasi berikutnya, Reuben.